第1章:人工知能(AI)の定義と多様な視点

概念としてのAI

人工知能(AI)とは、人間の知能を模倣する技術を指し、その定義は多岐にわたります。AIは、自律的に学習し、推論し、問題を解決する能力を持つシステムとされています。この概念には、データ分析、意思決定支援、パターン認識など、幅広い応用が含まれます。

AIのアプリケーションと実用例

AIの応用は多岐にわたり、医療診断、自動運転車、自然言語処理(NLP)など、さまざまな分野で使用されています。例えば、最新のNLPモデルであるGPT-4は、テキスト生成、翻訳、対話システムなどで高い性能を発揮しています。また、医療分野では、AIを活用した画像診断ツールが開発され、早期の病気発見に役立っています。

AIの解釈と異なる視点

AIの解釈にはいくつかの異なる視点があります。一方では、効率的なアルゴリズムの集合としてのAIがあり、他方では、人間の知性を超越する知的存在としてのAIもあります。これらの異なる視点は、AIの倫理的な影響や社会的な受容性に関する議論にも影響を与えています。例えば、強いAI(General AI)に対する懸念として、倫理的な意思決定の透明性や、人間の仕事に対する影響などが挙げられます。

第2章:TensorFlowのインストールガイドと最適化手法

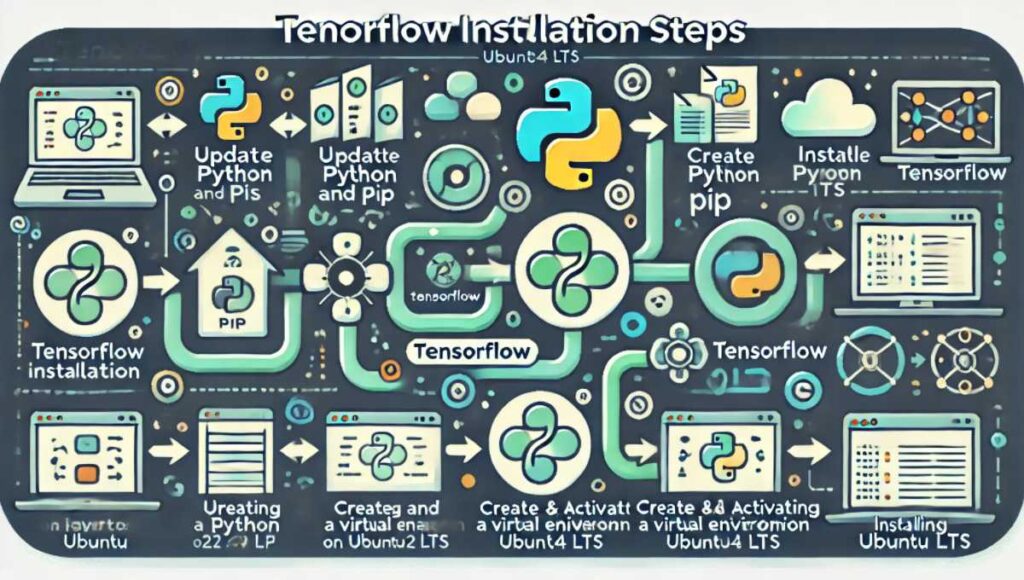

UbuntuへのTensorFlowインストール方法(2024年版)

2024年9月時点でのUbuntu環境にTensorFlowをインストールする手順を以下に示します。最新のUbuntu 22.04 LTSを使用し、Python 3.10以上のバージョンでのインストールが推奨されます。

- Pythonとpipのインストール・更新:

sudo apt update && sudo apt install python3-pip python3-dev - 仮想環境の作成:

python3 -m venv tensorflow_env - 仮想環境の有効化:

source tensorflow_env/bin/activate - TensorFlowのインストール:

pip install tensorflow

インストール後、python -c "import tensorflow as tf; print(tf.__version__)"でインストールが成功したかどうか確認できます。

Intel®向けTensorFlowの最適化とインストール手順

IntelのCPUを使用している場合、Intel向けの最適化版TensorFlowを使用することで、パフォーマンスを大幅に向上させることができます。以下は、Intel OneAPIを使用したインストール手順です:

- Intel OneAPIのインストール:

sudo apt install intel-oneapi-runtime-intelmpi intel-oneapi-mkl - Intel最適化版TensorFlowのインストール:

pip install intel-tensorflow - 環境変数の設定: Intelの最適化を最大限に活用するために、

export MKL_THREADING_LAYER=GNUを設定します。

これにより、TensorFlowはIntelの最適化ライブラリを利用して、計算速度を向上させます。

ソースからのTensorFlowインストールガイド

特定のカスタム構成や最適化が必要な場合、TensorFlowをソースからインストールすることが可能です。以下は、その手順です:

- 必要な依存関係のインストール: Bazelと必要なPythonパッケージをインストールします。

- TensorFlowリポジトリのクローン:

git clone https://github.com/tensorflow/tensorflow.git - ビルドの設定:

./configureコマンドを実行し、ビルドオプションを設定します。 - ビルドとインストール: Bazelを使ってTensorFlowをビルドし、生成されたホイールファイルをpipでインストールします。

PR:「先端AI技術搭載 ファイルを丸ごと翻訳・校正・要約【Languise】で簡単に。今すぐ試してみる

![]() 」

」

![]()

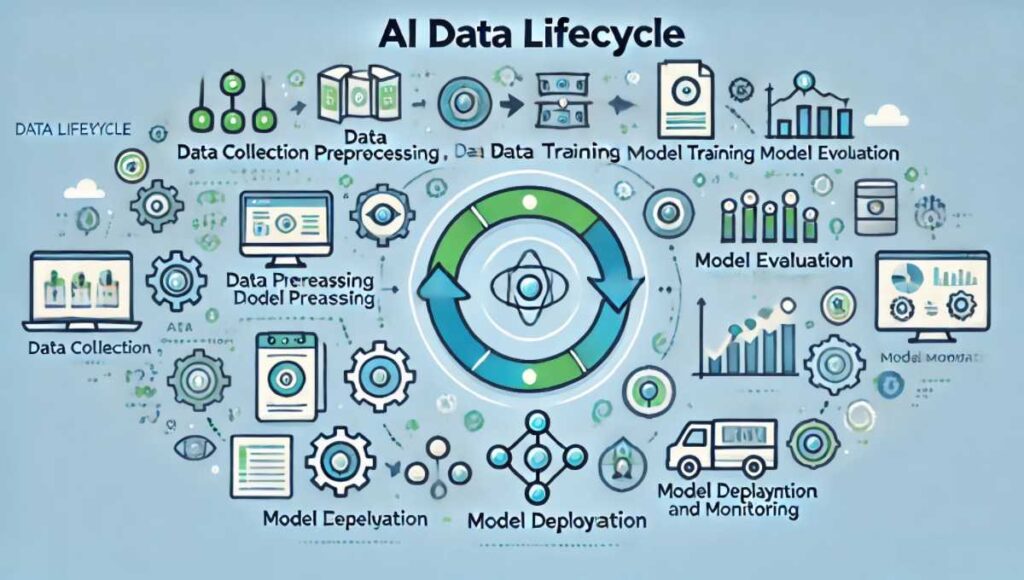

第3章:AIデータライフサイクルの概要と最新ツール

データ収集と前処理

AIプロジェクトにおけるデータライフサイクルの最初のステップは、データ収集と前処理です。2024年現在、データ収集には新しいツールやライブラリが利用されています。PolarsやPyTorchのDataLoaderを使用することで、データの取り扱いが効率化され、前処理の速度も向上します。

- Polarsによるデータ前処理: 高速なデータ操作と分析をサポートする最新ライブラリです。

- データ拡張と正則化手法: データの質を高めるために、データ拡張技術(例:回転、ズーム、シフトなど)を使用します。

モデルのトレーニングと評価

データが前処理されると、次にモデルのトレーニングと評価が行われます。最新の評価指標(例:ROC AUCの最新変種)を使用して、モデルの性能を詳細に評価します。

モデルのデプロイとモニタリング

トレーニングされたモデルを本番環境にデプロイするには、Weights & BiasesやNeptune.aiを使用することが推奨されます。これらのツールは、モデルのパフォーマンスモニタリングと継続的な改善を容易にします。

第4章:機械学習における分散トレーニング手法

Kubernetes上でのHorovodによる分散トレーニング

大規模なモデルを効率的にトレーニングするために、Kubernetesクラスタ上でHorovodを使用した分散トレーニングが利用されます。2024年の最新環境では、RayやNVIDIAの新しいGPU(例:H100)を活用することで、さらなる性能向上が期待できます。

- Rayのインストールと設定:

pip install rayを使用してRayをインストールし、分散トレーニング環境を構築します。 - NVIDIA H100の最適化: 最新のCUDAおよびcuDNNバージョンを使用して、GPUの性能を最大化します。

Intel® Xeon®プラットフォームでのマルチノードスケーリング

Intel® Xeon®プロセッサを使用したマルチノードスケーリングは、計算集約型タスクにおいて非常に効果的です。2024年には、MPI(メッセージパッシングインターフェース)を利用した高度な分散トレーニングが普及しています。

- MPIのインストール:

sudo apt install mpichなどを使用してMPIをインストールします。 - マルチノードトレーニングの実行:

mpirun -np 8 -ppn 4 -hosts host1,host2 python train.pyのようにして、複数のノードで分散トレーニングを行います。

第5章:TensorFlowのモデル作成とパフォーマンス最適化のベストプラクティス

事前トレーニング済みモデルとカスタムモデルの概要

TensorFlowでは、事前トレーニング済みモデルとカスタムモデルの両方を使用できます。事前トレーニング済みモデルは、ImageNetなどの大規模データセットでトレーニングされており、すぐに使用できるように設計されています。一方、カスタムモデルは特定のデータセットやタスクに最適化することができます。

CPU向けTensorFlowパフォーマンスの最適化手法

CPUでTensorFlowの性能を最大化するために、XLAコンパイラやIntel® MKL-DNNのような最適化ツールを使用します。

- XLAの有効化:

tf.config.optimizer.set_jit(True)を使用してXLAを有効にします。 - MKL-DNNの設定: Intel® CPUを使用している場合、MKL-DNNを使用することで、演算速度を大幅に向上させることができます。

Intel®ハードウェアを活用したTensorFlowのパフォーマンス強化

Intel® Xeon®プロセッサや最新のハードウェアを使用することで、TensorFlowのパフォーマンスをさらに向上させることができます。NUMAアウェアネスやメモリレイアウトの最適化など、高度な技術を使用してパフォーマンスを最大化します。

第6章:機械学習のための重要なデータセットと用語解説

CIFAR-10データセットの詳細と使用例

CIFAR-10は、画像分類タスクのベンチマークとして広く使用されているデータセットです。最新の研究では、より高度なデータ拡張技術や正則化手法を使用して、CIFAR-10での性能を向上させる試みが続けられています。

エポック、バッチサイズ、反復の違い

エポック、バッチサイズ、反復は、機械学習のトレーニングにおいて重要なパラメータです。エポックはデータセット全体をモデルに通す回数を指し、バッチサイズは1回の反復で処理するデータの数、反復は1エポック中のバッチ数を指します。

バッチサイズがモデルのパフォーマンスに与える影響

バッチサイズはモデルのトレーニング速度と性能に直接影響します。大きなバッチサイズはメモリ使用量を増やしますが、計算の効率を高めます。最新の研究では、バッチサイズと学習率の最適なバランスを見つけることが重要とされています。

第7章:AI技術に関連する最新のツールとライブラリ

VirtualenvとCondaを用いた環境管理

Pythonプロジェクトの依存関係を管理するために、VirtualenvやCondaが使用されます。これらのツールは、プロジェクトごとに分離された環境を提供し、依存関係の競合を防ぎます。

- Virtualenvの使用方法:

pip install virtualenvでインストールし、仮想環境を作成します。 - Condaの使用方法: Condaは、Pythonだけでなく他の言語やツールのパッケージ管理も行えるため、より多機能です。

Libffiライブラリとその用途

Libffiは、異なるプログラミング言語間で関数を呼び出すためのポータブルな高水準インターフェイスを提供します。特に、Pythonのctypesモジュールと連携して使用されることが多く、C言語の関数をPythonから呼び出す際に利用されます。

Dockerのインストールとカスタマイズ方法

Dockerは、アプリケーションをコンテナとしてパッケージ化し、デプロイするためのプラットフォームです。CentOSやRHELにDockerをインストールするには、公式リポジトリを追加してからyumを使ってインストールします。

第8章:クラウドとコンテナ技術の最新ガイド: AIインフラの構築方法

AWS Deep Learning AMIの起動と活用方法

Amazon Web Services(AWS)のDeep Learning AMIは、ディープラーニングフレームワークが事前インストールされた仮想マシンイメージです。これを使用することで、すぐにAIのトレーニングを開始できます。

- EC2インスタンスの起動: AWSマネジメントコンソールからDeep Learning AMIを選択し、適切なインスタンスタイプ(例:p3.2xlarge)でインスタンスを起動します。

- インスタンスの接続とセットアップ: SSHを使用してインスタンスに接続し、必要なパッケージやライブラリを設定します。

CentOSおよびRHELへのDockerインストールとコンテナ管理

CentOSやRHELにDockerをインストールしてコンテナを管理する方法を以下に示します。

- 公式リポジトリの追加:

sudo yum-config-manager --add-repo https://download.docker.com/linux/centos/docker-ce.repo - Dockerのインストール:

sudo yum install docker-ce docker-ce-cli containerd.io - Dockerサービスの起動と有効化:

sudo systemctl start docker && sudo systemctl enable docker

第9章:AIの応用例と今後の発展予測

小さな画像からの特徴学習手法

小さな画像からの特徴学習は、ディープラーニングの基礎研究として重要です。最新の研究では、CIFAR-10やMNISTなどのデータセットを使用して、階層的な特徴表現を学習する新しい手法が提案されています。

AI技術の今後の発展と可能性

AI技術は今後も急速に発展すると予想されます。自律的なAIシステムや量子コンピューティングとの統合により、AIの計算速度と効率が飛躍的に向上する可能性があります。また、AI倫理や透明性の向上も重要な研究テーマとして挙げられています。

これらの進展により、AIはより多くの産業分野で応用され、社会に大きな影響を与えることが期待されています。

用語の定義と一貫性についてのご注意

本記事で使用している「強いAI」と「弱いAI」という用語について、一般的には「強いAI」は「AGI(Artificial General Intelligence)」、「弱いAI」は「Narrow AI」として知られています。これらの用語の違いをより明確にするために、「強いAI(AGI)」とは、人間と同等またはそれ以上の知的能力を持ち、幅広いタスクを実行できるAIを指し、「弱いAI(Narrow AI)」は特定のタスクに特化したAIを指します。読者の皆様には、これらの用語の使い方に関する混乱を避けるため、改めて定義を確認いただければ幸いです。

NLPの最新技術に関する補足情報

記事内でGPT-4を「最新のNLPモデル」として言及していますが、より正確には、GPT-4は最新の生成型事前学習変換モデルの一つです。また、NLP分野には他にもT5(Text-To-Text Transfer Transformer)やBERT(Bidirectional Encoder Representations from Transformers)といった先進的なモデルがあります。これらのモデルはそれぞれ異なるアプローチや特性を持ち、特定のタスクで優れた性能を発揮しています。最新の技術動向を理解するために、これらのモデルも参考にしてください。

技術的な手順と最新情報についてのご注意

Ubuntu 22.04 LTSにおけるTensorFlowのインストール手順について、記事では「Python 3.10以上のバージョンでのインストールが推奨されます」と記載しましたが、これは一般的な推奨事項であり、特定のTensorFlowバージョンに最適なPythonのバージョンを確認することをお勧めします。TensorFlowの公式ドキュメントやリリースノートを参照し、最新の互換性情報を確認してください。

AI技術の説明と最新の動向

「AI技術は今後も急速に発展する」という記述に関して、より具体的な根拠として、量子コンピューティングとの統合が挙げられます。現在の研究では、量子コンピューティングの力を利用してAIの計算速度を飛躍的に向上させる試みが進められており、例えば、量子機械学習アルゴリズムの開発が注目されています。こうした進展は、AI技術の未来像を具体化する一助となるでしょう。

ソースからのTensorFlowインストール手順に関する補足

ソースからTensorFlowをインストールする手順について、初心者の方には少々難解かもしれません。詳細な手順や背景については、公式のTensorFlowガイド(公式ドキュメントリンク)を参照していただくことをお勧めします。また、必要に応じて専門家のサポートを受けるのも一つの方法です。

技術的なインストールコマンドに関する補足説明

「Intel OneAPIのインストール」に関するコマンドについて、記事では「sudo apt install intel-oneapi-runtime-intelmpi intel-oneapi-mkl」と記載しましたが、これらのコマンドはIntelの最適化ライブラリをインストールするためのものです。詳細な設定やこれらのライブラリの用途については、Intelの公式サイトやIntel OneAPIの公式ドキュメントを参照し、システム要件や用途に応じて最適な設定を行うことをお勧めします。

読者の皆様にとってより価値ある情報提供となることを期待しています。